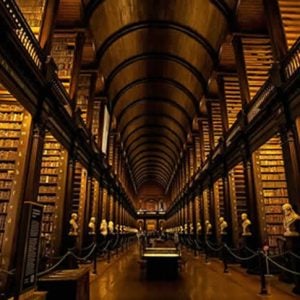

Se teindre les dents en noir, c’était beau

Dans certaines régions du Japon et d’Asie du Sud-Est, les dents noircies étaient autrefois un signe de beauté très recherché. Les gens appliquaient un vernis spécial sur leurs dents, qui agissait aussi comme un conservateur contre la carie.

Si cela peut sembler étrange ou effrayant aujourd’hui, les dents noires symbolisaient à l’époque la santé, l’élégance et la maturité. La tradition a disparu en grande partie, mais quelques communautés continuent à l’honorer.

Advertisements

Advertisements